DeepSeek本地部署指南,自定义Ollama和模型的安装部署位置详细教程

DeepSeek频繁出现“服务器繁忙,请稍后再试。”,很多人都逐步转为本地部署使用了,如何在自己电脑上搭建一套自己的deepseek呢?

三步即可,如果你需要帮助部署,可以联系博主哈。

安装ollama模型运行工具

安装deepseek模型

安装可视化插件

一、安装ollama

打开ollama官网,下载安装即可(下载地址:https://ollama.com/download)

根据你的系统,下载响应的安装包,进行安装。

注意:Ollama默认安装到C盘,如果想更换安装位置,不要直接安装,看下面

命令行进入Ollama的安装包目录,然后执行:.\OllamaSetup.exe /DIR="D:\Ollama"

DIR="你想安装的目录"

安装完成后,在cmd/命令行终端,输入`ollama -v`,看是否显示版本号,显示就代表安装成功。

二、安装deepseek模型

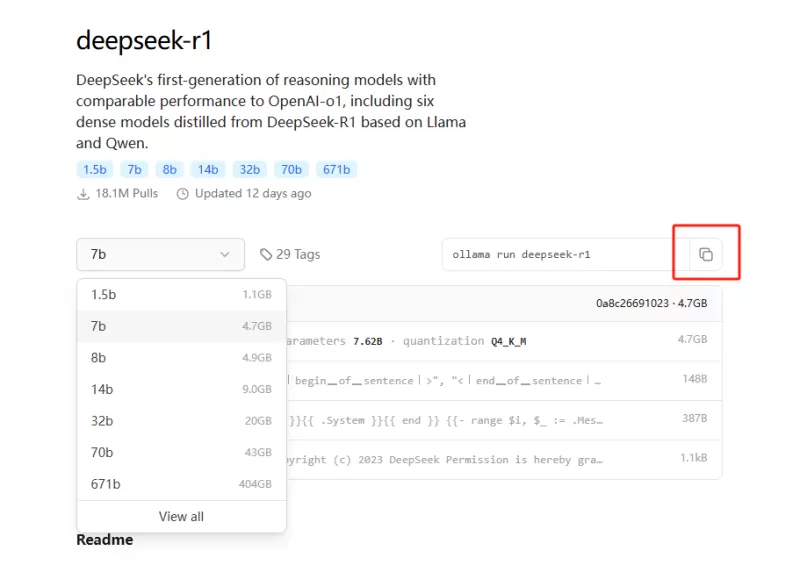

在ollama网站上搜索deepseek模型(https://ollama.com/search?q=deepseek),我们选择部署deepseek-r1模型。

打开模型页面后,可选择不同参数版本的模型下载。从模型大小和计算能力上有1.5B到671B不等。

这里的 “B” 代表 “Billion”,即“十亿”,因此:

● 1.5B 表示该模型具有 15 亿个参数,适合轻量级任务或资源有限的设备使用。

● 671B 则代表该模型拥有 6710 亿个参数,模型规模和计算能力都极为强大,适合大规模数据处理和高精度任务,但对硬件要求也相应更高。

根据自己电脑的配置选择适当的模型下载,复制右边的命令,如:ollama run deepseek-r1:8b

再次回到刚才的命令行终端(第一步的),将复制的命令粘贴进来,按回车执行命令。

安装好了,就可以使用deepseek了,只不过现在是在命令终端中使用,可能很多人不习惯这个简陋的黑黑的窗口。

接着就开始安装可视化的聊天界面了。

三、可视化界面

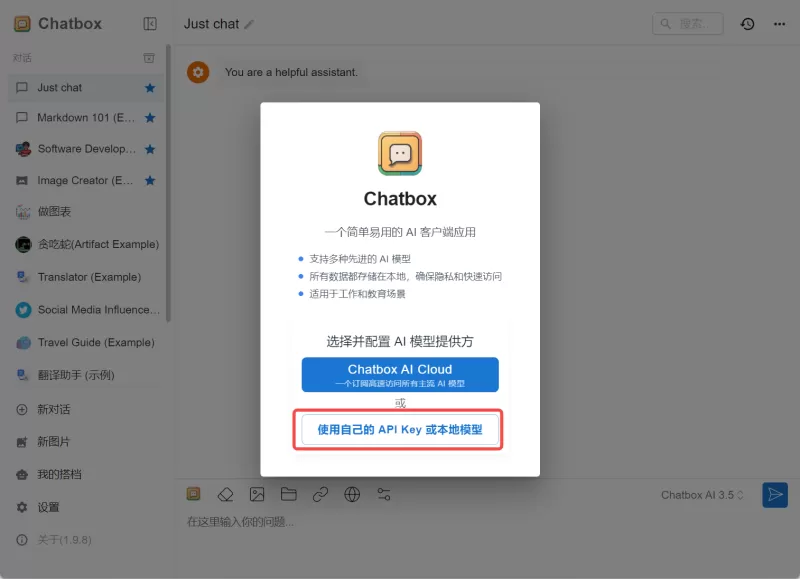

对于可视化界面,有很多可以选择,如chatBox AI、Cherry Studio等等。这里以chatBox为例。

进入chatBox官网,下载软件并安装(下载地址:https://chatboxai.app/zh#download)

安装好后,打开软件,选择“使用自己的API KEY或本地模型”

然后选择“Ollama API”

在弹框中“模型”选择框里选择刚刚安装好的模型(如本文中的deepseek-r1:8b)

其他参数自行调整,也可以直接默认。

然后,保存。

开始你的deepseek之旅吧!

四、进阶

Ollama模型默认安装在C盘,如果像更换位置的,接着看

模型文件默认存储位置如下:

Windows系统:C:\Users\<用户名>\.ollama\models目录下。

macOS系统:\~/.ollama/models目录下。

Linux系统:/usr/share/ollama/.ollama/models目录下。

在你想要存在模型的地方创建好文件夹,如(D:\Ollama\models)

然后将默认位置的模型剪切过来,

配置环境变量,配置在用户变量即可。

在Path变量中新增一个,填入Ollama的安装位置,如`D:\Ollama`

新增变量OLLAMA_MODELS,值为模型的位置,如`D:\Ollama\models`

验证,在命令行终端,输入`ollama list`,可以显示出来模型就代表成功。

有 0 位网友评论: